Hviske v3 conversation

Hviske v3 er Danmarks førende state-of-the-art transskriptionsmodel, udviklet af syv.ai. Denne version er specifikt finetunet på mange timers naturlige samtaler, hvilket gør den exceptionelt præcis til møder, interviews, podcasts og andre virkelighedsnære scenarier.

Modellen er bygget ovenpå CoRal-project/roest-whisper-large-v1 og er gratis at anvende under den angivne licens.

Du kan prøve modellen interaktivt og helt gratis på vores demo side.

Ydeevne & Benchmarks

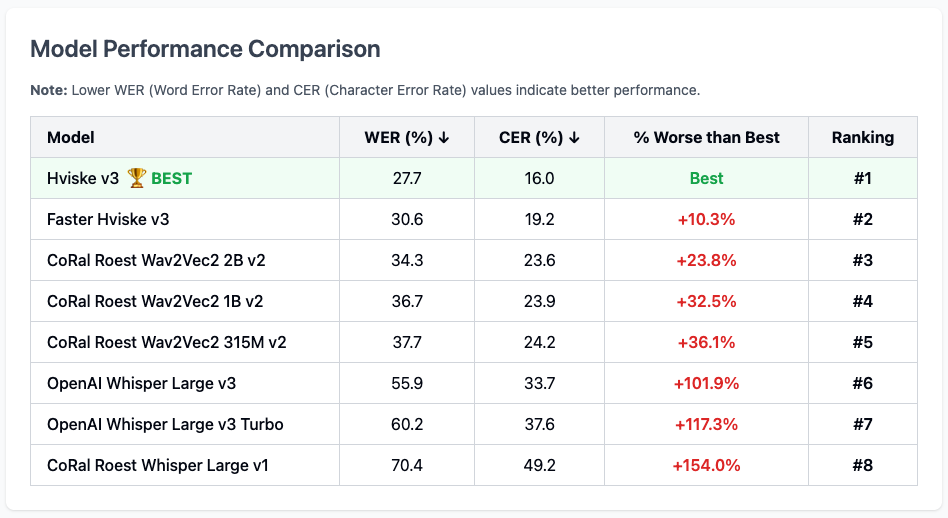

Hviske v3 sætter en ny standard for dansk tale-til-tekst. Vores omfattende benchmarks viser, at Hviske v3 overgår alle andre tilgængelige modeller, inklusiv OpenAI's Whisper Large v3 og v3 Turbo, med en markant lavere Word Error Rate (WER) og Character Error Rate (CER).

Lavere WER og CER værdier indikerer bedre performance.

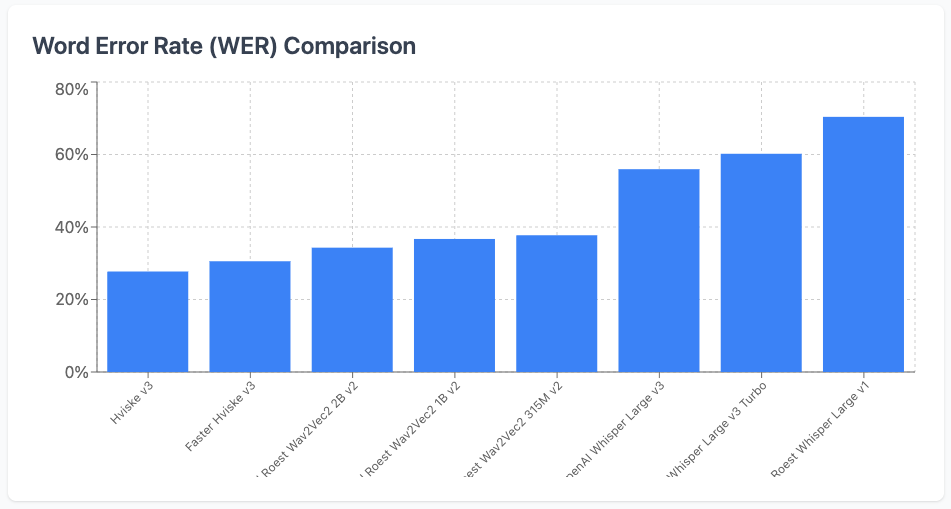

Sammenligning af Word Error Rate (WER)

Visualiseringen nedenfor viser tydeligt Hviske v3's førerposition sammenlignet med andre populære modeller.

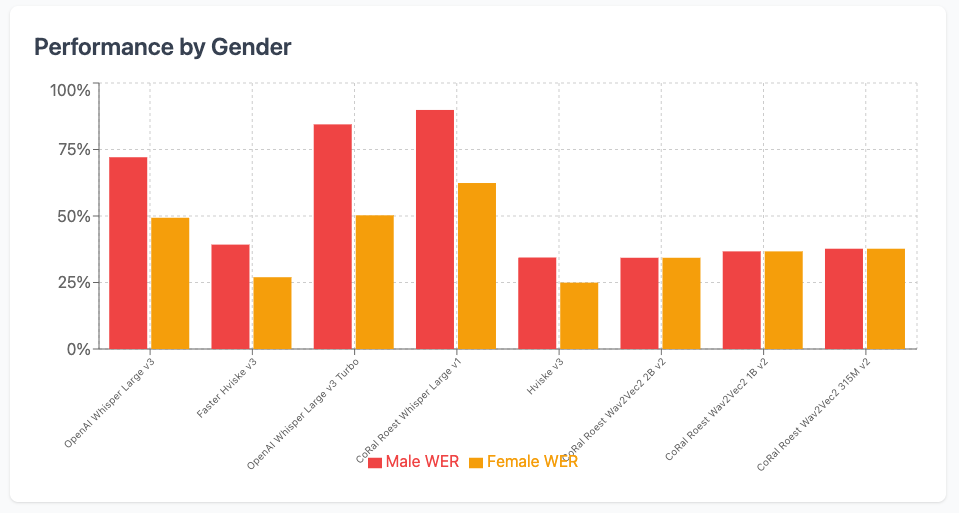

Analyse af kønsbias

Et centralt fokus for os er at udvikle fair og upartisk AI. Vores analyse viser, at Hviske v3 ikke har en næsten identisk performance på tværs af mandlige og kvindelige stemmer. Vi formoder, at dette skyldes, at test datasættet fra Coral kun indeholder stemmer fra 4 personer, og derfor ikke er repræsentativt. Vi formoder, at CER og WER for kvinder vil være på niveau med mænd når datasættes udvides.

Sådan kommer du i gang

Du kan nemt køre modellen lokalt ved hjælp af transformers biblioteket.

1. Installér de nødvendige pakker:

pip install transformers datasets torch accelerate

2. Kør Python-koden:

import torch

from transformers import AutoModelForSpeechSeq2Seq, AutoProcessor, pipeline

from datasets import load_dataset

# Sæt device og data type for optimal performance

device = "cuda:0" if torch.cuda.is_available() else "cpu"

torch_dtype = torch.float16 if torch.cuda.is_available() else torch.float32

# Angiv model ID for Hviske v3

model_id = "syvai/hviske-v3-conversation"

# Hent model og processor fra Hugging Face

model = AutoModelForSpeechSeq2Seq.from_pretrained(

model_id, torch_dtype=torch_dtype, low_cpu_mem_usage=True, use_safetensors=True

)

model.to(device)

processor = AutoProcessor.from_pretrained(model_id)

# Opret en ASR pipeline

pipe = pipeline(

"automatic-speech-recognition",

model=model,

tokenizer=processor.tokenizer,

feature_extractor=processor.feature_extractor,

max_new_tokens=128,

chunk_length_s=30,

batch_size=16,

torch_dtype=torch_dtype,

device=device,

)

# Eksempel: Transskriber en lydfil fra CoRal datasættet

# Du kan erstatte dette med din egen lydfil: f.eks. pipe("sti/til/din/lydfil.wav")

dataset = load_dataset("alexandrainst/coral", split="test", streaming=True)

sample = next(iter(dataset))["audio"]

result = pipe(sample)

print(result["text"])

Tak til

En stor tak til Innovationsfonden og alle de parter, der har bidraget til CoRal datasættet. Uden åbne og højkvalitets datasæt ville projekter som dette ikke være mulige.

Skal din virksomhed have hjælp?

syv.ai er Danmarks mest nørdede AI-konsulenthus. Vi hjælper virksomheder med alt fra strategisk rådgivning til udvikling og implementering af skræddersyede AI-løsninger i verdensklasse.

Kontakt os for at høre, hvordan vi kan hjælpe jer.

- Downloads last month

- 282

Model tree for syvai/hviske-v3-conversation

Base model

openai/whisper-large-v3